DEEP FAKES Assédio Constante

…o bot deepfake no Telegram foi bloqueado no iOS por violar as diretrizes da App Store, de acordo com os pesquisadores. O canal principal do Telegram que hospedava o bot e um canal afiliado para compartilhar suas criações também foram removidos. Mas…

São Paulo, 29/10 de 2020.

3 Minutos

Em junho de 2019, Vice descobriu a existência de um aplicativo perturbador que usava IA para “despir” mulheres. Chamado de DeepNude, ele permitia que os usuários carregassem uma foto de uma mulher vestida por US $ 50 e recebessem uma foto dela aparentemente nua.

Na verdade, o software estava usando redes adversárias geradoras, o algoritmo por trás dos deepfakes, para trocar as roupas das mulheres por corpos nus altamente realistas. Quanto mais mal vestida a vítima, melhor. Não funcionou em homens.

Em 24 horas, o artigo da Vice havia inspirado tal reação que os criadores do aplicativo rapidamente o retiraram. A conta DeepNude no Twitter anunciou que nenhuma outra versão seria lançada e ninguém mais teria acesso à tecnologia.

Mas, uma nova investigação da Sensity AI (anteriormente Deeptrace Labs), uma empresa de segurança cibernética focada em detectar o abuso de mídia manipulada, agora descobriu uma tecnologia muito semelhante sendo usada por um bot disponível publicamente no aplicativo de mensagens Telegram.

Desta vez, ele tem uma interface de usuário ainda mais simples: qualquer pessoa pode enviar uma foto ao bot pelo aplicativo Telegram para celular ou web e receber uma foto nua em minutos.

O serviço também é totalmente gratuito, embora os usuários possam pagar uma base de 100 rublos (aproximadamente US $ 1,50) por vantagens como remover a marca d’água nas fotos “removidas” ou pular a fila de processamento.

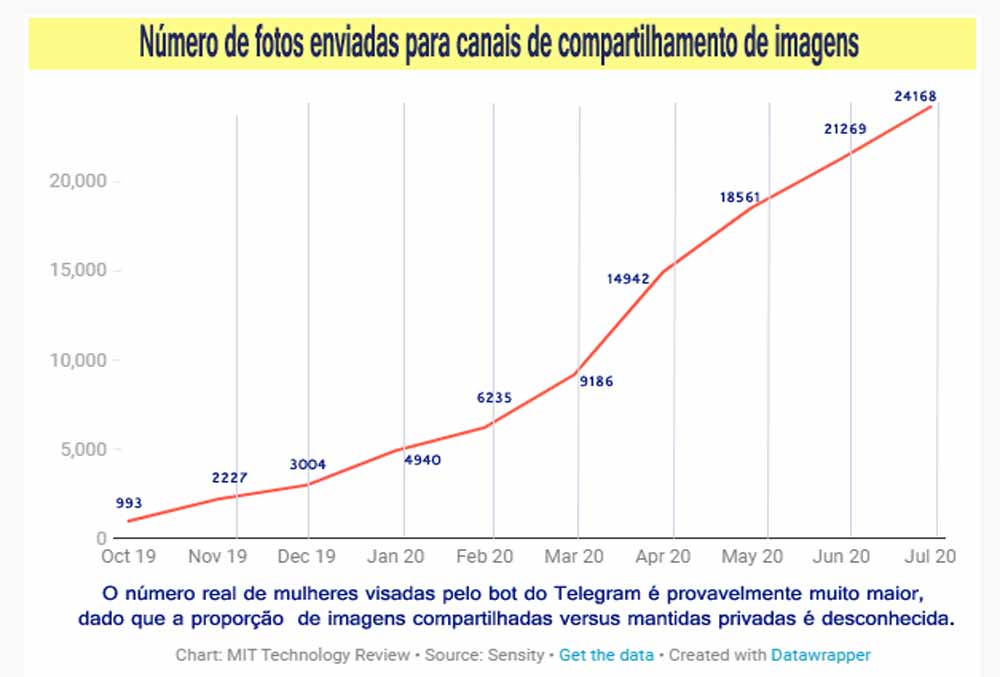

Em julho de 2020, o bot já havia sido usado para atingir e “despir” pelo menos 100.000 mulheres, a maioria das quais provavelmente não tinha ideia. “Normalmente são meninas”, diz Giorgio Patrini, CEO e cientista-chefe da Sensity, co-autor do relatório. “Infelizmente, às vezes também é bastante óbvio que algumas dessas pessoas são menores de idade.”

A Gamificação do Assédio

O deepfake bot, lançado em 11 de julho de 2019, está conectado a sete canais do Telegram com um total combinado de mais de 100.000 membros. (Este número não explica a adesão duplicada entre canais, mas só o grupo principal tem mais de 45.000 membros únicos.)

O canal central é dedicado a hospedar o próprio bot, enquanto os outros são usados para funções como suporte técnico e compartilhamento de imagens. Os canais de compartilhamento de imagens incluem interfaces que as pessoas podem usar para postar e julgar suas criações nuas.

Quanto mais uma foto é curtida, mais seu criador é recompensado com tokens para acessar os recursos premium do bot. “O criador receberá um incentivo como se estivesse jogando um jogo”, diz Patrini.

A comunidade, que pode ser facilmente descoberta por meio de pesquisa e mídia social, cresceu de forma constante no número de membros no último ano. Uma pesquisa com 7.200 usuários mostrou que cerca de 70% deles são da Rússia ou de outros países de língua russa.

As vítimas, no entanto, parecem vir de uma gama mais ampla de países, incluindo Argentina, Itália, Rússia e Estados Unidos. A maioria deles são indivíduos particulares que os usuários do bot dizem conhecer na vida real ou que encontraram no Instagram.

Os pesquisadores conseguiram identificar apenas um pequeno punhado de mulheres e tentaram contatá-las para compreender suas experiências. Nenhuma das mulheres respondeu, Patrini diz.

Os pesquisadores também contataram o Telegram e as agências de aplicação da lei relevantes, incluindo o FBI. O Telegram não respondeu à sua nota nem ao pedido de acompanhamento da MIT Technology Review para comentar.

Patrini diz que eles também não viram “nenhum efeito tangível nessas comunidades” desde o contato com as autoridades.

Os agressores têm usado imagens pornográficas para assediar mulheres há algum tempo. Em 2019, um estudo da American Psychological Association descobriu que uma em cada 12 mulheres acaba sendo vítima de pornografia de vingança em algum momento de sua vida.

Um estudo do governo australiano, analisando a Austrália, o Reino Unido e a Nova Zelândia, descobriu que essa proporção chega a ser de um em cada três. A pornografia de vingança falsa adiciona uma dimensão totalmente nova ao assédio, porque as vítimas não percebem que essas imagens existem.

Também há muitos casos em que deepfakes foram usados para atingir celebridades e outros indivíduos de alto perfil.

A tecnologia tornou-se popular nos recessos profundos da Internet como uma forma de trocar o rosto de celebridades por vídeos pornôs e tem sido usada como parte de campanhas de assédio para silenciar jornalistas.

Patrini diz que conversou com influenciadores e YouTubers também, que tiveram imagens pornográficas falsas deles enviadas diretamente para seus patrocinadores, custando-lhes imenso desgaste emocional e financeiro.

DeepFake a Vingança Pornô

Patrini suspeita que esses ataques direcionados podem piorar muito. Ele e seus colegas pesquisadores já viram o avanço e a disseminação da tecnologia. Por exemplo, eles descobriram outro ecossistema de mais de 380 páginas dedicadas à criação e compartilhamento de deepfakes explícitos na plataforma de mídia social russa VK.

(Após a publicação deste artigo, um porta-voz da VK enviou à MIT Technology Review uma declaração: “A VK não tolera esse tipo de conteúdo ou links na plataforma e bloqueia as comunidades que os distribuem. Faremos uma verificação adicional e bloquearemos conteúdo impróprio e comunidades.”)

Os pesquisadores também descobriram que o algoritmo ‘de despir’ está começando a ser aplicado a vídeos, como imagens de modelos de biquínis andando em uma passarela.

No momento, o algoritmo deve ser aplicado quadro a quadro – “é muito rudimentar no momento”, diz Patrini. “Mas tenho certeza de que as pessoas vão aperfeiçoar e também colocar um serviço de licença para isso.”

Infelizmente, ainda existem poucas maneiras de interromper esse tipo de atividade – mas a conscientização sobre os problemas está crescendo. Empresas como Facebook e Google, e pesquisadores que produzem ferramentas para criação de deepfake, começaram a investir mais seriamente em contramedidas como a detecção automatizada de deepfake.

No ano passado, o Congresso dos Estados Unidos também apresentou um novo projeto de lei que criaria um mecanismo para as vítimas buscarem recursos legais por danos à reputação.

Nesse ínterim, afirma Patrini, o Sensity continuará a rastrear e relatar esses tipos de deepfakes maliciosos e buscar entender mais sobre as motivações daqueles que os criaram e os impactos nas vidas das vítimas. “Na verdade, os dados que compartilhamos neste relatório são apenas a ponta do iceberg”, diz ele.

Publicado pela MIT Review